Het gebruik van AI in bedrijven, publieke organisaties en binnen overheden brengt altijd risico's met zich mee. AI wordt soms op een manier gebruikt die niet voor iedereen even eerlijk is, of die ondoorzichtig is waardoor je niet kunt controleren wat er nu precies gebeurt in zo'n AI-systeem. De term black box, komt je misschien wel bekent voor. In AI is er sprake van een black box systeem als het AI-systeem inzichten produceert op basis van data, maar waarvan de eindgebruiker en vaak ook de ontwikkelaar niet weet hoe de inzichten tot stand komen. Een bekend voorbeeld is onderzoek van het MIT Media Lab, waaruit bleek dat in veel AI voor gezichtsherkenning de gezichten van mannen veel beter worden herkend dan die van vrouwen en hoe donkerder je huid, hoe slechter de gezichtsherkenning scoort. Bekijk het filmpje 'Gender Shades' maar eens: (De video is Engelstalig. Je kunt ondertiteling aanzetten en automatische vertaling instellen door in de video rechtsonder ⚙️/Instellingen aan te klikken en daar bij ondertiteling automatisch vertalen te selecteren en de juiste taal te kiezen.)

Ethische aspecten

Ethische bedreigingen die bij AI applicaties een grote rol spelen, zijn onder meer vooringenomenheid (of bias), het probleem van ondoorzichtigheid(of opacity) en de mogelijkheid van discriminatie.

- Vooringenomenheid

- Vooringenomenheid wil zeggen dat iemand al een oordeel klaar heeft voordat men de feiten onder ogen krijgt. De Toeslagenaffaire bijvoorbeeld, toont (onder meer) het grote belang aan van het voorkomen van vooringenomenheid. Het staat inmiddels vast dat de Belastingdienst een “institutioneel vooringenomen” werkwijze heeft gehanteerd: grote groepen burgers zijn op grond van afkomst gekwalificeerd en zijn als fraudeur weggezet.

- Ondoorzichtigheid

- Ondoorzichtigheid gaat er over dat iets niet goed te snappen is. Als voor een AI-systeem niet kan worden uitgelegd hoe dit systeem tot besluiten komt is deze besluitvorming ondoorzichtig ofwel een black box systeem. Ondoorzichtigheid is natuurlijk niet alleen een AI probleem, wanneer iemand bijvoorbeeld erg onduidelijk is over de besteding van zakgeld dan kun je zeggen dat “zijn uitgavenpatroon erg ondoorzichtig is”.

- Discriminatie

- Discriminatie is letterlijk “het maken van onderscheid”. Het gaat dan in AI applicaties over het niet onterecht onderscheid maken tussen mensen of groepen, oftewel het niet gelijk behandelen van gelijke gevallen. Bij sollicitaties blijft dit bijvoorbeeld en belangrijk probleem.

Dit soort bedreigingen zijn met elkaar verbonden. Vooringenomenheid kan schuilen in complexe, ondoorzichtige modellen, met discriminatie tot gevolg. In plaats daarvan willen we dat onze AI-systemen eerlijk en verklaarbaar zijn en op een goede manier met gegevens omgaan.

Vooringenomenheid (bias)

Vooringenomenheid of bias kan in het geval van een AI-toepassing ontstaan door bijvoorbeeld data waarin die vooringenomenheid al aanwezig is, zoals in het Gender-Shades voorbeeld. Maar het kan ook zijn dat de gebruikte algoritmen niet neutraal zijn. Soms zijn meningen direct in code ingebed.

Denk bijvoorbeeld maar eens aan koken. Een recept is eigenlijk een soort algoritme. Het doel is om een maaltijd samen te stellen. De ingrediënten en hoeveelheden van elk ingrediënt die je nodig hebt, zijn daarbij de parameters van een model. Een belangrijk aspect bij het schrijven van zo'n recept is het definiëren van succes: wanneer is een maaltijd geslaagd? Misschien geef je veel om een stevige smaak en moet je recept daarom juist veel vet, zout en suiker bevatten. Maar anderen vinden wellicht hun gezondheid belangrijk en stoppen vooral veel voedingsstoffen in hun recept, terwijl het weinig vet, zout en suiker bevat. Zo'n definitie van succes bevat daarom ook altijd meningen én vooroordelen.

En dat geldt ook voor een algoritme. Een model dat optimaliseert voor een bepaalde definitie van succes is niet per se neutraal. Het is belangrijk om hier rekening mee te houden: een rekruteringsalgoritme, een algoritme dat helpt bij het aannemen van nieuw personeel, kan worden geoptimaliseerd om werknemers te selecteren die het meeste geld voor een bedrijf verdienen, maar dit gaat ten koste van teamwerk of moreel gedrag. Een organisatie moet goed nadenken over deze afwegingen, en nadenken over waar zij voor optimaliseert. Onthoud daarom dat AI geen volledig neutrale beslissing kan garanderen. Maar besef ook dat een mens dat ook niet kan.

Doorzichtigheid

Een tweede, en aanverwant probleem is ondoorzichtigheid. We staan hier nog even stil bij het begrip black box . Meestal verwijst dit begrip naar complexe modellen zoals neurale netwerken of deep learning algoritmen, die zichzelf versterken en moeilijk te controleren zijn omdat ze zoveel berekeningen bevatten. Maar ondoorzichtigheid, het probleem van niet begrijpen wat AI van plan is, kan ook van toepassing zijn op veel eenvoudigere algoritmen. Laten we eens kijken waarom.

Er kunnen verschillende bronnen van ondoorzichtigheid zijn als het gaat om AI, niet alleen complexiteit:

- Bewust vaag houden vanwege concurrentievoordeel: bedrijven willen soms niet dat iemand hun algoritme begrijpt; een algoritme kan een belangrijke bron van concurrentievoordeel zijn. Geheim houden van hoe het werkt, kan ook gamen van een algoritme voorkomen. Als sollicitanten bijvoorbeeld weten naar welke trefwoorden een algoritme in een cv zoekt, kunnen ze deze woorden gewoon in het document plaatsen om geselecteerd te worden.

- De technische geletterdheid onder de algemene bevolking vrij laag: zelfs een eenvoudig algoritme kan voor veel mensen moeilijk te begrijpen zijn.

- Mensen en machines redeneren anders: het is bijvoorbeeld moeilijk voor een AI-systeem om uit te leggen waarom het denkt dat het naar een kat kijkt, terwijl een mens dat moeiteloos kan uitleggen.

- Leveranciershype: bedrijven verkopen soms nep-AI. Bijvoorbeeld door te beweren dat ze een nieuwe geavanceerde chatbot hebben, maar deze wordt feitelijk aangedreven door mensen. Soms wordt een media-rage strategisch gebruikt om te verbergen wat er echt achter de schermen gebeurt.

Discriminatie

De meeste organisaties willen niemand discrimineren. Maar ze hebben soms niet door dat hun systemen discriminerende effecten hebben, zeggen onderzoekers die het effect van discriminatie op AI bestuderen. AI kan bijvoorbeeld mensenrechten en andere belangrijke waarden bedreigen, zoals het recht op non-discriminatie. Eén van de problemen is dat AI onbedoeld kan leiden tot ongeoorloofde en oneerlijke discriminatie. Dat kan onder meer gebeuren als een AI-systeem leert van menselijke beslissingen die discrimineren.

Om mensen tegen oneerlijke discriminatie door AI te beschermen hebben we aanvullende regelgeving nodig. Zo simpel is dat echter ook weer niet, want het gebruik van AI-systemen is te gevarieerd voor één set regels. In verschillende sectoren staan verschillende waarden op het spel. Daarom worden vaak sectorspecifieke regels overwogen. Later in deze les leer je meer over de regelgeving rondom AI.

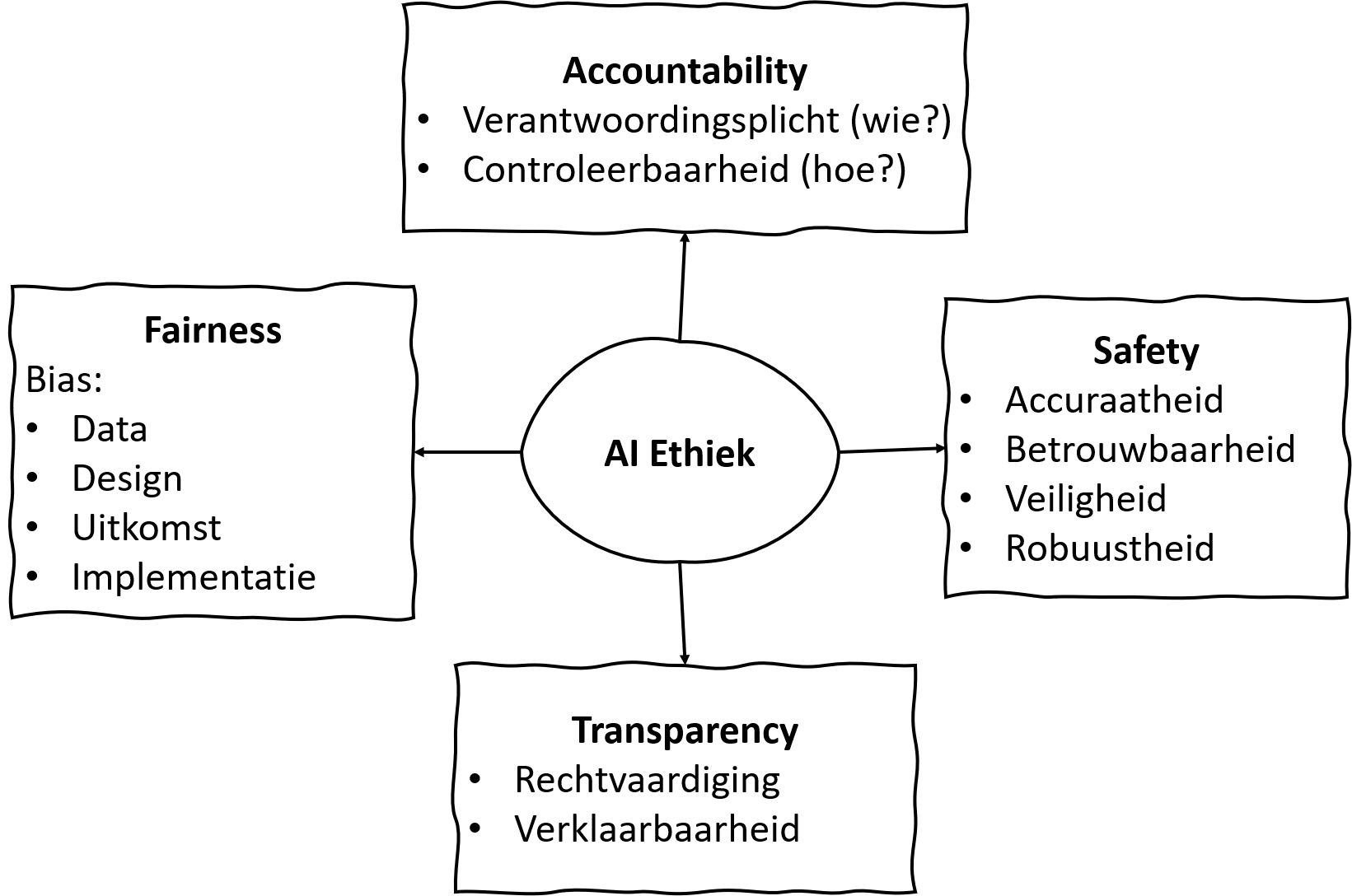

De FAST principes

Dus hoe open je die zwarte doos van AI, om ervoor te zorgen dat je alleen eerlijke, verklaarbare, veilige en transparante AI-systemen gebruikt? Het is natuurlijk allereerst belangrijk dat je ervoor zorgt dat je op de hoogte bent en blijft van de ontwikkelingen. Volg opleidingen om te snappen wat de techneuten bedoelen, en volg je instinct. Maar daarnaast wordt er door allerlei organisaties geïnvesteerd in protocollen en standaarden voor eerlijk, verantwoord en transparant gebruik van AI. Daarin staan vaak de zogenaamde FAST-principes centraal: FAST staat daarbij voor fairness, accountability, safety en transparency.

Fairness

Het is belangrijk om je te realiseren dat AI-systemen zijn ontworpen door mensen, die zijn gebonden aan de beperkingen van hun context en vooroordelen. Zo zal iedere AI racistisch zijn ten gunste van zijn makers - een Japanse AI zal totaal anders redeneren dan een Amerikaanse of Duitse omdat de sociale waarden in deze landen verschillen. Als je als gebruiker weet dat een AI-systeem met vooringenomenheid gebouwd is, kun je er ook op anticiperen.

De beperkingen in de context kunnen dus in de systemen terecht komen. Er kan bijvoorbeeld bias (vooringenomenheid ) optreden bij het verzamelen en analyseren van gegevens. Het Gender Shades onderzoek uit de video is daar een goed voorbeeld van, de data bestond merendeels uit foto’s van blanke personen. Het is cruciaal om ervoor te zorgen dat trainings- en testdatasets die gebruikt worden om de applicatie te laten leren representatief genoeg zijn voor het doel dat de applicatie beoogt (inclusief data van verschillende bevolkingsgroepen en minderheden), dit om fouten en discriminatie in de applicatie te voorkomen. Het is dus al nodig om bias te analyseren tijdens het ontwerp van de AI applicatie. In de volgende paragraaf gaan we dieper in op eisen aan data.

Behalve analyse van bias in de trainings- en testdatasets moet ook worden gekeken naar bias die optreedt tijdens het leerproces van het AI-systeem ofwel in de verwerking van de data naar het resultaat van een AI-systeem. Komen er in deze stap nog discriminerende effecten naar boven? Als laatste is het belangrijk dat de het AI-systeem alleen gebruikt wordt door deskundigen die zijn opgeleid om deze applicatie op een verantwoorde en onbevooroordeelde manier toe te passen. Bij de Monocam applicatie bijvoorbeeld krijgen alleen agenten de mogelijke overtreders te zien. Het eindoordeel ligt daar nog steeds bij de mens, al is die wel heel goed geholpen door het voorsorteren van vele opnames van voertuigen.

Accountability

Het principe van accountability vereist dat de verantwoordelijkheid voor beslissingen gemaakt door AI-systemen ligt bij de menselijke ontwikkelaars van de systemen en de gebruikers die de systemen in de praktijk toepassen. Het gaat dan eigenlijk over twee aspecten. De verantwoordingsplicht, die iets zegt over wie verantwoordelijk is voor een uitkomst van zo'n systeem. En controleerbaarheid, dat inspeelt op hoe ontwikkelaars en gebruikers verantwoordelijk moeten worden gehouden: als bijvoorbeeld een AI systeem een antwoord geeft moet er door de verantwoordelijken uitgelegd kunnen worden hoe dit antwoord tot stand is gekomen. Het is belangrijk om de verantwoordelijkheid in alle stadia te bewaken, van systeemontwikkeling tot het moment waarop het systeem wordt toegepast in de praktijk en tot wanneer het uiteindelijk niet langer gebruikt wordt en verwijderd wordt.

Safety

Het veiligheidsprincipe vereist dat, afhankelijk van de praktische setting, het systeem nauwkeurig is en binnen een verwacht foutenpercentage werkt. Een AI-systeem moet betrouwbaar zijn, om consistente resultaten te genereren. Het moet veilig zijn en daardoor de privacy en vertrouwelijkheid van gegevens die gebruikt worden waarborgen. En een AI-systeem moet robuust zijn, om zelfs bij onverwachte veranderingen en verstoringen de bediening te garanderen. Stel je bijvoorbeeld eens voor dat de Monocam, zoals gepresenteerd in de videoles van de Nationale Politie voortdurend foute beslissingen neemt wanneer het harder waait dan windkracht 4.

Transparency

Het laatste FAST-principe is transparantie. Beperkte transparantie kan de betrouwbaarheid van AI-systemen verminderen en de validatie van de resultaten en de identificatie van fouten en vooroordelen belemmeren. Daarom is het noodzakelijk om alle gevolgde processen tijdens het ontwerp en het gebruik van een AI-systeem te kunnen beoordelen. Het moet mogelijk zijn om de basisgedachte achter de beslissingen of het gedrag van een systeem te begrijpen. Er wordt in relatie tot transparantie ook wel gesproken over zogenaamde explainable AI. Het doel van explainable AI is om AI-beslissingen transparanter en betrouwbaarder te maken.

Transparantie binnen AI omvat de volgende twee betekenissen:

- Verklaarbaarheid: De mogelijkheid om te achterhalen hoe en waarom een AI-systeem een acteert in een bepaalde situatie en men dus de logica van de beslissing of het gedrag kan begrijpen. Dit noemt men ook wel het openen van de ‘black box’ van AI.

- Rechtvaardiging: Men moet kunnen aantonen dat zowel het ontwerp en de inzet van een AI-systeem een rechtvaardiging heeft met betrekking tot de punten, ethisch toelaatbaar, niet-discriminerend/eerlijk, publiek vertrouwenswaardig en het garanderen van veiligheid.

Om transparantie te bieden is het dus de taak om voor AI-systemen eerst het systeem te rechtvaardigen. Als daarna het systeem is ontwikkeld moet er voor leken een uitleg komen hoe en waarom een systeem werkt. Als laatste moet er dan weer een rechtvaardiging komen van het gedrag van het AI-systeem. Goede initiële intenties kunnen namelijk alsnog verkeerd uitpakken.

De FAST-principes gaan over het hele AI-systeem. In de volgende paragraaf concentreren we op problemen rond de data waarvan AI-systemen afhankelijk zijn.